|

摘要:

基于上下文的離線元強化學習(Context-basedOMRL)通過構建一個上下文編碼器,將收集到的上下文數據映射到任務表征,進一步基于任務表征來自適應的在多個環境中進行決策。然而,在離線的情形下,任務表征的編碼器極大的依賴于用于訓練的離線數據的豐富程度。當數據采集有限,以至于與特定采樣策略的特點耦合時,學習的任務編碼器通常…

|

基于上下文的離線元強化學習(Context-based OMRL)通過構建一個上下文編碼器,將收集到的上下文數據映射到任務表征,進一步基于任務表征來自適應的在多個環境中進行決策。然而,在離線的情形下,任務表征的編碼器極大的依賴于用于訓練的離線數據的豐富程度。當數據采集有限,以至于與特定采樣策略的特點耦合時,學習的任務編碼器通常會難以獲得較好的泛化能力,進而影響元強化學習的性能。

基于此,南京大學&南棲仙策團隊合作提出了一種基于模型對抗樣本增強的環境特征編碼器學習,task Representation learning via adversarial Data Augmentation (ReDA)算法,并發表在AAMAS24會議上。這一方法可以應用于元強化學習的環境特征識別上,緩解了以往算法中環境特征和采樣策略耦合的影響,從而使得我們在樣本受限的實際場景中可以提升環境特征編碼器的泛化能力,進而提高元學習策略的表現,推進強化學習在現實世界的應用落地。

離線元強化學習環境特征耦合問題

離線元強化學習(Offline Meta Reinforcement Learning)是一種重要的機器學習技術,其結合了離線和元學習兩種方法優勢,可以幫助智能系統從以往的多種環境的離線經驗中學習,以提高在新環境下的泛化能力。通過離線數據,系統可以更有效地利用以往的經驗,而無需實時與環境進行交互,從而提高數據利用效率。并且,由于在不同的環境下進行學習,而不僅僅是在當前環境下,也極大的提高了策略的泛化能力。

在很多實際應用中,實時與多種環境交互收集數據可能會很昂貴或不切實際,離線元強化學習為這些場景提供了解決方案。離線元強化學習可以使強化學習技術更易于應用和部署,在提高泛化能力、數據效率、穩健性以及降低成本等方面具有重要意義,尤其是在實際應用中,如機器人控制與路徑規劃、自動駕駛系統、智能游戲角色、智能物流和倉儲以及工業自動化等方面具有廣泛的用途。

離線元強化學習中,主要的方法是基于上下文的離線元強化學習。該類方法將策略建模為兩部分:第一部分是環境特征提取器,可以將歷史收集到的上下文數據映射到環境特征上;第二部分是基于環境特征的條件策略,在給定的當前狀態和得到的環境特征的條件下進行決策。第一部分的任務編碼器是非常重要的,提取的環境特征將直接決定了下游的元策略的學習質量和泛化能力。

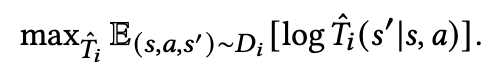

然而,以往的環境特征編碼學習需要依賴非常豐富且多樣的數據進行學習,這在很多真實的物理場景中是不現實甚至存在一定危險的,比如機器人等。以往的工作中,環境特征提取是基于對比學習直接在離線數據集上進行訓練的:

由于對比學習直觀上就是減小相同任務的上下文表征的距離,增大不同環境的上下文表征的距離,通常需要收集到非常豐富的離線數據集來獲得一個魯棒且可泛化的環境表征,例如CORRO[1]需要使用整個訓練期間的所有策略檢查點來收集數據,這在真實場景中是不現實的,顯然整個訓練流程中的數據對于現實任務例如機器人控制任務是很難獲取的,甚至獲取過程中存在一定的不安全因素。因為很多時候我們無法獲取如此豐富的樣本來訓練一個好的環境特征編碼器,所以我們需要去關注數據集有限時環境編碼器的學習問題。

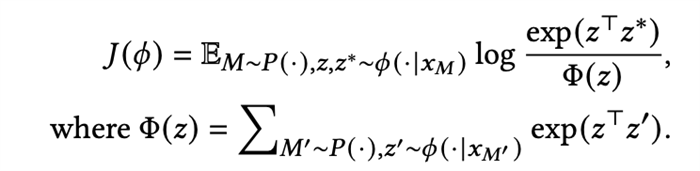

簡單以倒立桿任務(InvertedPendulum)為例,我們的訓練數據是重力1.0下的高質量數據和重力2.0下的低質量數據,然后使用上下文數據是1.0倍重力下的低質量的數據進行測試(圖1-a),對數據集的分布進行降維可視化展示(圖1-b),發現測試數據到同樣環境下的訓練數據的距離,并沒有相對其他環境的訓練數據的距離更加接近(圖1-c),這樣的情況下,僅僅依賴于數據集的對比學習,由于缺少足以代表環境任務特征的樣本,將很難保證任務表征的泛化能力。

圖1. (a). 訓練數據和測試數據 (b). 數據分布的可視化 (c). 測試數據到不同任務的訓練數據的相對距離

基于模型的對抗樣本增強

為了讓環境特征編碼器更好地捕捉到環境特征而非采樣策略本身的特征,我們提出了一種基于模型的對抗樣本增強的方法,產生更多的不同于數據集的數據來訓練環境特征編碼器。

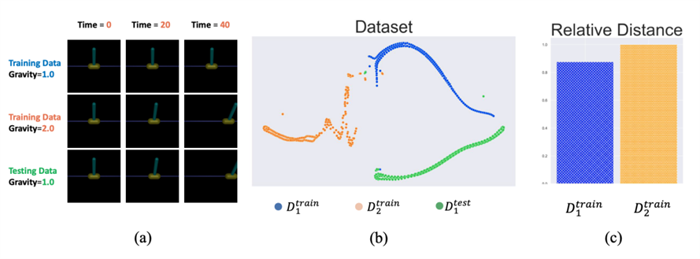

首先我們基于每個任務的數據集,分別學習各個任務上的轉移模型:

在學習好可以用來交互的環境模型后,接下來我們需要面臨的問題是:1.采集什么樣的樣本來有效增強任務編碼器的能力?2.如何緩解環境模型誤差帶來的影響?

對于這兩個問題,我們引入了一個對抗采樣策略,該策略的優化目標主要由三部分組成:

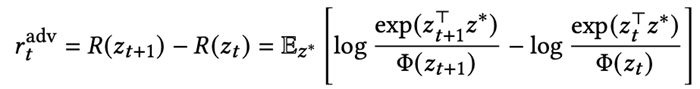

·最小辨識度的樣本:我們需要采集讓任務編碼最難區分的樣本,即該樣本到相同任務的距離和到其他任務的距離差距不大。所以我們考慮這樣的樣本需要具備的特點是,當它被加入上下文之后,會導致基于上下文的對比學習的損失函數上升。所以我們使用該損失函數變化的程度來作為優化的獎勵信號,如果對比損失上升越大,說明該樣本的引入使得任務編碼器更加難以識別環境了。定義該樣本加入前的任務表征為z_t,加入該樣本后的任務表征為z_t+1,單步的獎勵定義為:

·模型不確定性懲罰:我們并不希望對抗策略去搜索模型中誤差過于大的區域,所以參考MOPO我們基于不確定性度量給出對樣本的懲罰。

·任務相關獎勵:我們使用了任務的獎勵函數來避免對抗策略去搜索和任務無關的樣本。

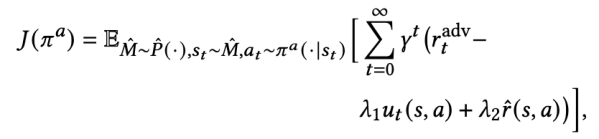

綜上所述,我們最終得到了在模型上搜索對抗樣本的對抗策略的優化目標:

基于該對抗策略搜索到的增強樣本,我們得到了新的環境特征編碼器的優化目標:

該目標是一個標準的強化學習的定義,所以可以使用SAC等算法求解。

整體的算法流程如下圖所示,首先基于離線數據集學習轉移模型,然后在轉移模型上獲得對抗策略,并產生對抗數據訓練任務編碼器,再基于任務編碼器訓練最終的元策略。

圖2. 算法流程

整體訓練的算法描述如下:

技術驗證

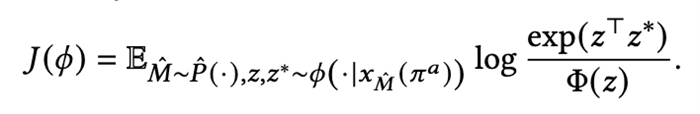

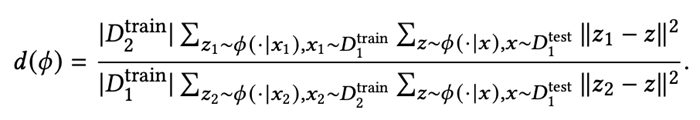

基于倒立桿的環境與數據集,我們對我們的方法進行了簡單的驗證,首先定義相對距離:

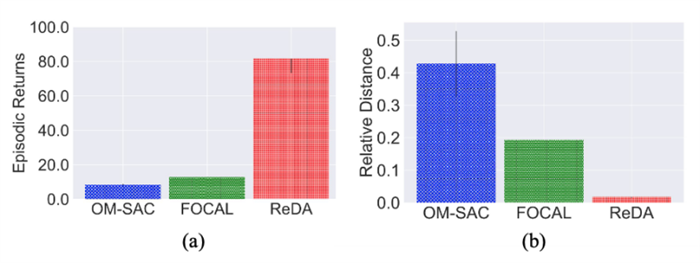

該距離描述了相同任務下訓練集和測試集的距離與不同任務下訓練集和測試集的距離的差異,如果該距離越小,說明我們的表征訓練的泛化能力越好,通過和FOCAL[2]等基礎算法進行對比,我們發現ReDA顯著的提升了表征的泛化能力(圖3-b),并且取得了更好的測試性能(圖3-a)。這一結果表明,我們學習到的環境表征解耦了采樣的策略特征,從而更好的泛化到了更多數據上。

圖3. 倒立桿多種方法下的表征與性能

整體性能

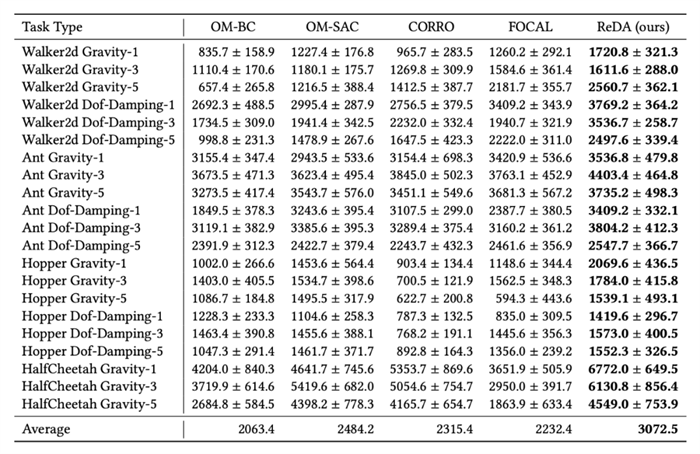

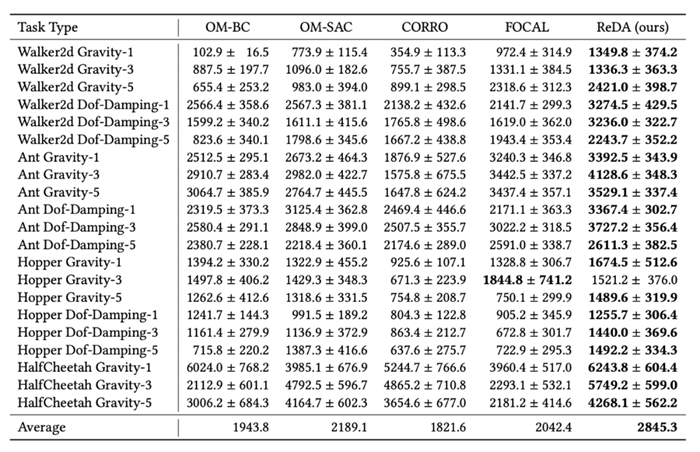

我們設計了兩種模式進行測試,第一種是on-policy模式,上下文的樣本來源于當前策略的采樣;另一種是off-policy模式,策略來源于數據集以外的其他樣本。這兩者都是在實際部署時最常需要使用的上下文樣本,并且都存在和訓練集存在一定的偏差。我們參考以往的工作構建了MuJoCo上的多任務數據集,包括HalfCheetah、Hopper、Walker2d、Ant在Gravity、Dof-Damping等模擬器參數變化下的多任務數據集。在訓練過程中我們只使用幾個檢查點的數據,然后使用其他檢查點的數據作為off-policy模式下的測試數據。實驗結果如下:

圖4. on-policy模式下的性能

其中[任務] [參數類型]-[數字]的格式表示使用的訓練數據集是哪個任務的哪類參數,總共使用了幾個檢查點的數據去訓練。

圖5. off-policy模式下的性能

其中[任務] [參數類型]-[數字]的格式表示使用的訓練數據集是哪個任務的哪類參數,總共使用了幾個檢查點的數據去訓練。

可以看到,通過引入基于模型的方法,學習一個泛化能力更強的環境特征提取器,極大地提高了元策略的表現,使離線元強化學習得以在樣本受限的情況下仍然取得一個不錯的性能。

本文關注低數據情境下的離線元強化學習(OMRL),強調了環境表示學習與數據收集策略分離的重要性,并提出了對抗數據增強的實際解決方案;訓練了轉移模型和對抗性策略來增強離線數據集,以應對數據集受限的情況。希望這項研究能夠激發對數據采樣策略在元強化學習中的影響,以及OMRL測試基準標準化的進一步探索。

參考文獻

[1]. Haoqi Yuan et al. obust Task Representations for Offline Meta-Reinforcement Learning via Contrastive Learning. (ICML 22)

[2]. Lanqing Li et al. FOCAL: Efficient Fully-Offline Meta-Reinforcement Learning via Distance Metric Learning and Behavior Regularization. (ICLR 21)

|